DeepSeek는 어떤 회사인가

DeepSeek의 정식 명칭은 항저우 심층 탐색 인공지능 기초 기술 연구 유한회사(杭州深度求索人工智能基础技术研究有限公司)로, 2023년 7월 17일에 설립된 혁신적인 기술 회사로, 첨단 대언어 모델(LLM) 및 관련 기술 개발에 집중하고 있습니다. DeepSeek 의 법인위치는 저장성 항저우시 궁수구 환청북로 169번지 후이진국제빌딩 1201호실이며 법정 대리인은 페이티엔(裴湉)입니다

# LLM(Large Language Model, 대형 언어 모델)은 방대한 양의 텍스트 데이터를 학습하여 자연어를 이해하고 생성할 수 있는 인공지능(AI) 모델을 의미합니다. LLM은 인공지능의 한 분야인 자연어 처리(NLP, Natural Language Processing) 기술을 기반으로 하며, 딥러닝(Deep Learning) 알고리즘을 활용해 훈련됩니다. LLM의 주요 특징으로는

1) 방대한 데이터 학습이 가능하여 인터넷, 책, 논문, 기사 등 다양한 출처에서 수집한 텍스트 데이터를 학습하여 지식을 축적할 수 있습니다.

2) 자연어 이해 및 생성이 가능하여 사람이 쓰는 언어를 이해하고, 문장을 생성하거나 요약하는 등의 작업을 수행할 수 있습니다.

3) 문맥 인식 능력이 있어 이전 문맥을 기반으로 적절한 답변을 제공하며, 문장의 흐름을 파악하는 능력이 뛰어납니다.

4) 다양한 응용이 가능하여 챗봇, 번역, 콘텐츠 생성, 코딩 지원, 논문 요약 등 다양한 분야에서 활용됩니다.

LLM은 트랜스포머(Transformer) 라는 신경망 아키텍처를 기반으로 동작합니다. 특히 어텐션 메커니즘(Self-Attention) 을 활용하여 문맥을 이해하고, 다음 단어나 문장을 예측하는 방식으로 학습됩니다.

대표적인 LLM 예시

GPT-4, GPT-3.5 (오픈AI)

DeepSeek-V2 (중국 딥시크)

Gemini (구글 DeepMind)

Claude (Anthropic)

Mistral, LLaMA (메타)

2025년 1월 27일, DeepSeek 애플리케이션이 애플 미국 지역 앱스토어 무료 앱 다운로드 순위에서 1위를 차지했으며, 미국 지역 다운로드 순위에서 ChatGPT를 넘어섰습니다. 같은 날, 애플 중국 지역 앱스토어 무료 목록에 따르면, DeepSeek가 중국 지역 1위가 되었습니다. 공개된 보도에 따르면, DeepSeek의 직원 규모는 OpenAI의 1/5에도 미치지 못하며, 100명 초반의 회사 중 연산자, 추론 프레임워크, 멀티모달 등의 연구개발 엔지니어와 딥러닝 분야의 연구원이 약 70명 있습니다. 주로 베이징 지부에 있으며, 나머지 30여 명은 항저우 본사에 있습니다.

< 주주정보 >

| 대주주명 | 宁波程恩企业管理咨询合伙企业 | 99% | 990만 위안 |

| 주주명 | 량원펑(梁文锋) | 1% | 10만 위안 |

# 량원펑(梁文锋, Liang Wenfeng)은 중국의 전기공학자이자 기업가로, 인공지능(AI) 기업 딥시크(DeepSeek)의 설립자입니다. 1985년 중국 광둥성 잔장시에서 태어나 저장대학교에서 정보전자공학 학사와 석사 학위를 취득하였습니다. 대학 시절부터 AI와 금융을 접목하는 시도를 하였으며, 2008년 금융위기 당시 금융 시장 데이터를 수집하고 머신러닝을 활용한 퀀트 트레이딩을 연구하였습니다.

2015년에는 대학 친구 2명과 함께 하이-플라이어(high-flyer)라는 헤지펀드를 설립하여 컴퓨터 트레이딩에 딥러닝 기법을 적용하였고, 이 펀드는 큰 성공을 거두어 운용자산이 80억 달러(약 11조 5천억 원) 규모로 성장하였습니다. 하이-플라이어는 2019년부터 AI 개발을 위해 엔비디아의 GPU 1만 개를 확보하며 AI 칩 클러스터를 구축하였고, 량원펑은 2023년 5월 하이-플라이어의 AI 연구소를 독립시켜 딥시크를 설립하였습니다.

딥시크는 저비용으로 고성능 AI 모델을 개발하여 주목받고 있으며, 특히 2023년 11월 첫 오픈소스 AI 모델인 '딥시크 코더'를 공개한 이후, '딥시크-V2', '딥시크-V3', 그리고 최근 공개된 '딥시크-R1'을 통해 세계의 주목을 받고 있습니다. 딥시크에 따르면, V3 모델 개발에 소요된 비용은 약 557만 6천 달러로, 이는 메타(Meta)가 최신 AI 모델 '라마3'를 훈련하는 데 사용한 비용의 10분의 1 수준입니다.

량원펑은 AI 기술의 민주화를 강조하며, "AI는 모두가 누리고 사용할 수 있어야 한다"고 말하였습니다. 그의 이러한 접근은 AI 업계에 새로운 경쟁과 혁신의 바람을 불러일으키고 있습니다.

2025년 1월 28일 소식에 따르면, DeepSeek는 서비스 상태 페이지에 다음과 같이 공지했습니다: 최근 DeepSeek 온라인 서비스가 대규모 악의적인 공격을 받아 지속적인 서비스 제공을 위해 +86 휴대폰 번호(중국휴대폰번호) 외의 등록 방식을 일시적으로 제한했으며, 등록된 사용자는 정상적으로 로그인할 수 있습니다.

주요상품

2024년 1월 5일, DeepSeek LLM이 발표되었으며, 이는 심층 탐색의 첫 번째 대형 모델입니다. DeepSeek LLM은 670억 개의 매개변수를 포함하고 있으며, 2조 개의 토큰이 포함된 데이터 세트에서 처음부터 훈련되었습니다. 데이터 세트는 중영문을 포함하고 있습니다.

모든 오픈 소스 DeepSeek LLM 7B/67B Base와 DeepSeek LLM 7B/67B Chat은 연구 커뮤니티에서 사용됩니다. DeepSeek LLM 67B Base는 추론, 코딩, 수학 및 중국어 이해 측면에서 Llama270B Base를 능가합니다. DeepSeek LLM 67B Chat은 코딩 및 수학에서 뛰어난 성능을 보이고 있습니다. 그것은 또한 헝가리 국가 고등학교 시험에서 65점을 획득하는 등 현저한 일반화 능력을 보여주었습니다. 물론, 그것은 중국어에도 능숙합니다. DeepSeek LLM 67B Chat은 중국어 성능에서 GPT-3.5를 능가합니다.

● 2024년 1월 25일, DeepSeek-Coder가 발표

DeepSeek Coder는 일련의 코드 언어 모델로 구성되어 있으며, 각 모델은 처음부터 2조 개의 토큰에서 훈련됩니다. 데이터 세트에는 87%의 코드와 13%의 중영 자연어가 포함되어 있습니다. 코드 모델 크기는 버전 1B에서 33B까지 다양합니다. 각 모델은 프로젝트 수준 코드 코퍼스에서 사전 훈련을 통해 16K 창 크기와 추가 빈 채우기 작업을 사용하여 프로젝트 수준 코드 보완 및 채우기 작업을 지원합니다. DeepSeek Coder는 다양한 프로그래밍 언어와 다양한 벤치마크 테스트에서 오픈 소스 모델의 최첨단 성능을 달성했습니다.

● 2024년 2월 5일, DeepSeekMath가 발표

DeepSeekMath는 DeepSeek-Coder-v1.57B를 기반으로 Common Crawl에서 추출한 수학 관련 토큰 및 자연어 및 코드 데이터에 대해 계속해서 사전 훈련을 진행하며, 훈련 규모는 5,000억 토큰에 달합니다.

"5,000억 토큰" 이란, 5,000억 개의 단어나 문자 조각을 학습 데이터로 사용했다는 뜻입니다.

● 2024년 3월 11일, DeepSeek-VL이 출시

DeepSeek-VL은 오픈 소스 시각-언어(VL) 모델로, 고정된 토큰 예산 내에서 고해상도 이미지(1024x1024)를 효율적으로 처리할 수 있는 하이브리드 시각 인코더가 사용되었습니다. 이 설계는 모델이 다양한 시각적 작업에서 중요한 의미론과 세부 정보를 포착할 수 있는 능력을 보장합니다. DeepSeek-VL 시리즈(1.3B 및 7B 모델 포함)는 동일한 모델 크기에서 광범위한 시각-언어 벤치마크 테스트에서 최첨단 또는 경쟁 가능한 성능을 달성했습니다.

● 2024년 5월 7일, 2세대 오픈 소스 Mixture-of-Experts(MoE) 모델인 DeepSeek-V2를 출시

DeepSeek-V2는 경제적이고 효율적인 훈련과 추론을 특징으로 하는 강력한 혼합 전문가(MoE) 언어 모델입니다. 여기에는 총 2,360억 개의 매개변수가 포함되어 있으며, 그 중 각 토큰은 210억 개의 매개변수를 활성화합니다. DeepSeek 67B와 비교하여 DeepSeek-V2는 더 강력한 성능을 달성했을 뿐만 아니라 42.5%의 훈련 비용을 절감하고 KV 캐시를 93.3% 줄였으며 최대 생성 처리량을 5.76배로 증가시켰습니다.

DeepSeek-V2는 8.1조 토큰을 포함하는 다양하고 고품질의 코퍼스에서 사전 훈련되었습니다. 포괄적인 사전 훈련을 완료한 후 감독 미세 조정(SFT) 및 강화 학습(RL)을 통해 모델의 잠재력이 더욱 발휘되었습니다.

평가 결과는 방법의 효율성을 검증했으며 DeepSeek-V2는 표준 벤치마크 테스트 및 개방형 생성 평가에서 상당한 성과를 거두었습니다. DeepSeek V2 모델은 중국어 종합 능력 평가에서 뛰어난 성과를 보이며, 매우 낮은 추론 비용으로 업계의 주목을 받고 있습니다.

● 2024년 6월 17일, DeepSeek-Coder-V2가 출시

DeepSeek-Coder-V2는 오픈 소스 하이브리드 전문가(MoE) 코드 언어 모델로, 코드 특정 작업에서 GPT4-Turbo와 동등한 성능을 달성했습니다.

DeepSeek-V2의 중간 체크포인트에서 시작하는 DeepSeek-Coder-V2는 추가 6조 토큰을 사전 훈련하여 DeepSeek-V2의 코딩 및 수학적 추론 능력을 크게 향상시키면서 공통 언어 작업에서 상당한 성능을 유지합니다. 그리고 코드 관련 작업, 추론 능력 및 일반 능력 등 여러 측면에서 상당한 진전을 이루었습니다. 또한 DeepSeek-Coder-V2는 지원되는 프로그래밍 언어를 86개에서 338개로 확장하고 컨텍스트 길이를 16K에서 128K로 확장합니다.

그리고 표준 벤치마크 테스트에서 DeepSeek-Coder-V2는 GPT4-Turbo, Claude 3 Opus 및 Gemini 1.5 Pro와 같은 폐쇄 소스 모델을 능가하는 코딩 및 수학적 벤치마크 테스트에서 우수한 성능을 보였습니다.

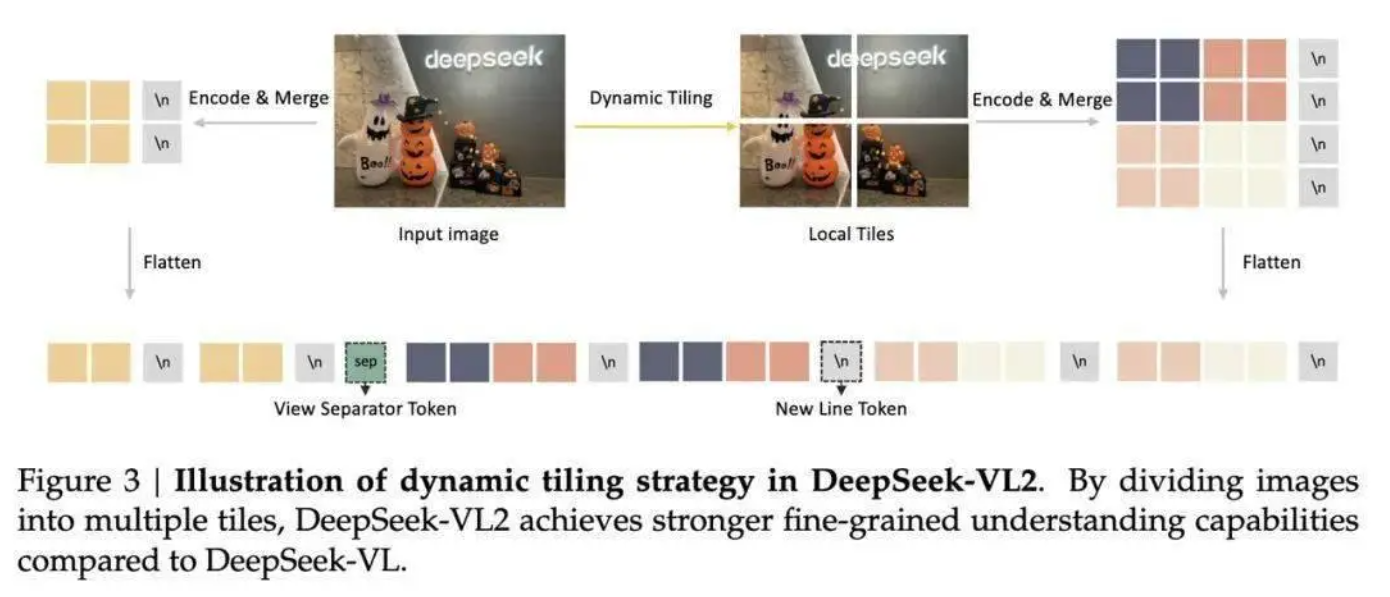

● 2024년 12월 13일, 고급 다중 모드 이해를 위한 전문가 혼합 시각 언어 모델인 DeepSeek-VL2가 출시

DeepSeek-VL2는 첨단 대형 혼합 전문가(MoE) 시각-언어 모델 시리즈로, 이전 DeepSeek-VL에 비해 현저히 개선되었습니다. DeepSeek-VL2는 시각적 질의응답, 광학 문자 인식, 문서/표/그래프 이해 및 시각적 위치를 포함하되 이에 국한되지 않는 다양한 작업에서 탁월한 능력을 보여주었습니다. 모델 시리즈는 각각 10억, 28억 및 45억 활성화 매개변수를 갖는 DeepSeek-VL2-Tiny, DeepSeek-VL2-Small 및 DeepSeek-VL2의 세 가지 변이체로 구성됩니다. DeepSeek-VL2는 기존의 오픈 소스 집약적 모델 및 MoE 기반 모델과 비교하여 유사하거나 더 적은 활성화 매개변수에서 경쟁력 있는 또는 최첨단 성능을 달성했습니다.

● 2024년 12월 26일 저녁, AI 회사 딥씨크(DeepSeek)가 새로운 시리즈 모델 DeepSeek-V3의 첫 번째 버전을 공식 출시하고 동시에 오픈 소스를 공개

지식 태스크(MMLU, MMLU-Pro, GPQA, SimpleQA)에서 DeepSeek-V3의 수준은 이전 세대의 DeepSeek-V2.5에 비해 크게 향상되어 현재 가장 성능이 좋은 모델인 Anthropic사가 10월에 발표한 Claude-3.5-Sonnet-1022에 가깝습니다. 미국 수학 경시대회(AIME 2024, MATH)와 전국 고등학교 수학 리그(CNMO 2024)에서 DeepSeek-V3는 다른 모든 오픈 소스 모델을 크게 초과했습니다. 또한, 생성 속도에서 DeepSeek-V3의 생성 토어 속도는 20TPS(Transactions Per Second가 초당 완료하는 트랜잭션 수)에서 60TPS로 크게 향상되었으며, V2.5 모델에 비해 3배 향상되어 더욱 원활한 사용 경험을 제공합니다.

● 2025년 1월 20일, DeepSeek는 DeepSeek-R1 모델을 공식 출시하고 오픈 소스 모델 가중치를 동기화함

DeepSeek-R1은 후 훈련 단계에서 대규모로 강화 학습 기술을 사용하여 라벨링된 데이터가 거의 없는 상황에서 모델 추론 능력을 크게 향상시켰습니다. DeepSeek-V3와 DeepSeek-R1 두 대형 모델은 비용이 저렴하고 성능이 OpenAI와 비슷하여 실리콘밸리를 놀라게 했고, 심지어 메타 내부의 공포를 불러일으켰습니다. 엔지니어들은 DeepSeek의 성과를 밤새 복제하려고 시도하기 시작했습니다.

# 참고로 현재 DEEPSEEK의 지식데이터는 23년 12월을 기준으로 운영 중입니다. #

DeepSeek의 신세대 모델 발표는 AI 대형 모델의 응용이 점차 보편적으로 이루어질 것임을 의미하며, AI 응용의 광범위한 실행을 지원합니다. 동시에 훈련 효율이 크게 향상되어 추론 계산 능력의 수요 증가에도 기여할 것으로 예상됩니다. DEEPSEEK는 AI 산업 체인의 가속화된 실행 기회를 지속적으로 긍정적으로 보고 있으며, AI 응용, AI Infra, AI 컴퓨팅 파워라는 세 가지 주요 주제에 주목하여 줄 것을 권하고 있습니다.

CHAT GPT에게 DEEPSEEK와의 차이점을 질문했습니다.

1. 개발사 및 배경

- ChatGPT (OpenAI)

- 미국 OpenAI에서 개발한 대형 언어 모델(LLM)입니다.

- GPT-4, GPT-3.5 등 다양한 버전을 운영하며, OpenAI의 API와 챗봇 서비스로 제공됩니다.

- OpenAI는 AI 윤리 및 안전성을 고려하여 모델을 개발하고 운영합니다.

- DeepSeek (DeepSeek.AI, 중국)

- 중국 기업 DeepSeek.AI에서 개발한 대형 언어 모델입니다.

- 2023년부터 AI 모델을 공개하기 시작했으며, 코드, 수학, 논리적 추론에 특화된 모델을 출시 중입니다.

- 최근 DeepSeekMath, DeepSeek-Coder, DeepSeek-V2 등을 발표하며 빠르게 성장하고 있습니다.

2. 모델 아키텍처 및 규모

- ChatGPT (GPT-4, GPT-3.5)

- OpenAI의 GPT-4는 1조 개 이상의 파라미터를 보유한 초거대 모델입니다.

- 자연어 이해, 창의적 글쓰기, 코딩, 번역 등 다방면에서 뛰어난 성능을 보입니다.

- API 및 유료 서비스(GPT-4 Turbo)로 제공됩니다.

- DeepSeek (DeepSeek-V2, DeepSeekMath, DeepSeek-Coder)

- DeepSeek-V2는 700억(70B) 파라미터 모델로, OpenAI의 GPT-4보다는 작지만, 빠른 연산 속도와 효율성을 목표로 합니다.

- DeepSeekMath는 수학 문제 해결에 특화된 모델로, 5,000억 개의 토큰을 학습하여 높은 성능을 보입니다.

- DeepSeek-Coder는 프로그래밍과 코딩에 특화된 모델로, 코드 작성 및 디버깅을 지원합니다.

3. 주요 기능 및 특화된 영역

비교 항목 ChatGPT (GPT-4) DeepSeek (DeepSeek-V2, Math, Coder)

| 자연어 처리 | 매우 강력함 | 우수하지만 GPT-4보다 약간 부족함 |

| 코딩 지원 | 강력한 코딩 지원 (ChatGPT Code Interpreter)가능 | DeepSeek-Coder가 특화됨 |

| 수학 문제 해결 | 논리적 사고 가능하지만 전문 수학 AI는 아님 | DeepSeekMath가 수학에 최적화됨 |

| 창의적 글쓰기 | 스토리, 에세이, 시나리오 작성 가능함 | 기본적인 문서 생성 가능함 |

| 번역 및 다국어 지원 | 여러 언어 지원, 품질 우수함 | 중국어 기반 모델로, 영어/중국어 강점 다른 언어는 아직 미흡 |

| API 및 서비스 | OpenAI API 제공, GPT-4 Turbo 사용 가능함 | 일부 API 제공, 모델 오픈소스 배포 |

| 학습 데이터 | 2023년까지 학습 (최신 정보는 웹 검색 필요) 가능함 | Common Crawl 및 수학/코딩 데이터 중점 |

| 비용 및 접근성 | 유료 서비스(GPT-4 Turbo) / 무료 버전(GPT-3.5) | 일부 오픈소스 모델 무료 제공 |

4. 차이점 요약

- ChatGPT(GPT-4)는 다재다능한 범용 AI,

- 자연어 처리(NLP), 번역, 코딩, 창작, 데이터 분석 등에 강함.

- OpenAI에서 개발한 고성능 상용 모델로 API와 유료 서비스 제공.

- DeepSeek은 특정 영역(수학, 코딩)에 특화

- DeepSeekMath : 수학 문제 해결 능력 우수.

- DeepSeek-Coder : 코드 생성 및 분석에 강점.

- OpenAI의 GPT-4보다는 작은 모델이지만, 특정 기능에 집중하여 효율적으로 설계됨.

CHAT GPT는 DeepSeek에 대해 결론을 아래와 같이 내렸습니다.

- ChatGPT는 다방면에서 강력한 범용 AI이며, 고품질의 자연어 처리 및 창의적 작업 수행에 적합합니다.

- DeepSeek은 수학 및 코딩과 같은 특정 영역에서 높은 성능을 발휘하며, 중국 내 AI 경쟁에서 주목받고 있는 모델입니다.

즉, ChatGPT는 "올라운더", DeepSeek은 "특정 분야의 전문가" 라고 볼 수 있습니다.

'경제 소식 > 해피재키 경제소식' 카테고리의 다른 글

| 제23차 세계한인비즈니스대회 미리보기 🌍 (6) | 2025.02.22 |

|---|---|

| 미국 신정부 관세조치 내용 및 현지 반응 요약 🌎 (1) | 2025.02.04 |

| 중국 2025년 경제 전망, 유력 키워드는 '소비진작'과 '부동산 안정' 🏠 (2) | 2025.01.01 |

| 중국알짜기업 'Power China' 중국전건을 소개 합니다. (1) | 2024.07.16 |

| 효과적인 법인카드 사용법 알아보기 (0) | 2024.07.07 |